Coded Bias e o viés nas novas tecnologias

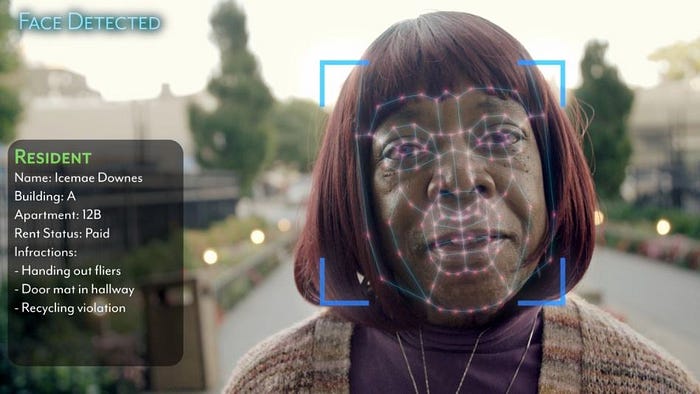

A Netflix colocou em seu catálogo um documentário chamado Coded Bias, que discorre sobre o uso de algoritmos de aprendizado de máquina nos dias atuais e como eles podem ter (e normalmente têm) um viés condizente com a nossa sociedade machista e racista. Além disso, acaba falando sobre os possíveis problemas de privacidade provenientes de tecnologias como detecção de faces, quando utilizadas por governos e grandes empresas.

TL;DR

Dentro dos documentários que cobrem esse assunto, esse é o melhor que eu já vi em termos de conteúdo. Tem alguns pequenos problemas que irei apontar mais à frente, mas, no geral, passa muito bem a mensagem de que temos que ter regulamentação para essas novas tecnologias, já que seu uso indiscriminado pode trazer muitos malefícios para a sociedade como um todo.

AI não é maligna

A tecnologia em si não é maligna. Ela traz diversos benefícios para o nosso dia a dia. Porém, dada a capacidade de impacto que a AI possui nos tempos atuais, ela pode ser utilizada para causar danos irreparáveis, como, por exemplo, ajudar a eleger governantes extremistas que acabam colocando um país inteiro numa espiral de mortes desnecessárias.

Outro ponto que normalmente as pessoas comentam é que a AI vai substituir os humanos, o que não é verdade (pelo menos não com o que temos hoje). A tecnologia atinge seu ápice quando aliada com a capacidade humana. De um lado, a máquina faz contas, toma decisões baseadas em dezenas ou centenas de fatores e/ou reproduz ações simples/tediosas. O humano, por outro, cria, interage com os demais e analisa o contexto das decisões. A longo prazo, a maioria dos trabalhos (motorista, caixa de supermercado, entre outros) será provavelmente substituída ou, pelo menos, terá mínima quantidade de interferência humana. É por isso que, como sociedade, devemos começar a discutir (e também implementar) uma renda básica universal, além de refletir sobre o futuro do trabalho, mas isso é assunto para outro post.

Ao invés de pensar numa AI que toma uma decisão jurídica automaticamente, podemos criar um modelo que busca decisões já tomadas no passado, avalia similaridades e diferenças entre essas decisões e analisa os possíveis vieses nelas envolvidos (raça, gênero, entre outros). O mais importante é ter diversidade de visões sobre modelos que afetam a sociedade, de forma a termos uma noção maior da situação, para, então, modificarmos o que for necessário e, assim, não causarmos impactos negativos.

Modelos e algoritmos podem ser ferramentas para aprender e remover vieses. No documentário fala-se muito sobre o preconceito que os modelos possuem por serem alimentados com dados já enviesados. Esse é um ponto muito importante e que os profissionais da área devem ter sempre em mente. Ao mesmo tempo, temos hoje já algumas formas de detectar essas disparidades e poderíamos, com isso, removê-las ou, pelo menos, atenuar muito o seu impacto.

Exemplo: entrevistadores humanos possuem preconceitos e tomam decisões muitas vezes sem perceber que estão sendo guiados por algum viés pessoal ou cultural, mas poderíamos ter um modelo que verifica as análises e procura por esses vieses implícitos de forma a corrigi-los ou apontá-los.

Fontes sobre viés e justiça em modelos:

Man Is to Computer Programmer as Woman is to Homemaker? De-biasing Word Embeddings.

A Survey on Bias and Fairness in Machine Learning

Pontos Positivos

- Pontos de vista humano: fazer um documentário sobre modelos matemáticos não é simples e colocar uma protagonista e diversas outras pessoas mostrando como essa tecnologia afeta a vida desses seres humanos é, com certeza, a melhor forma de instigar as pessoas a pensarem e a se interessarem sobre o assunto.

- Exemplo reais: falar sobre tecnologia é sempre complexo para quem não é da área, mas é muito fácil simpatizar e entender como um professor que é bem visto pelos alunos e pelos superiores pode sofrer com uma nota dada por um algoritmo. E não acho que ter uma nota automatizada seja ruim, mas ela deve ser explicável para que a pessoa saiba o que pode melhorar e a análise final deve ser humana, levando em conta o contexto. Além disso, é apenas com a visão humana que iremos conseguir melhorar o modelo, que nunca será perfeito. Um score de performance deveria ser apenas mais uma ferramenta para que a avaliação da pessoa seja realizada.

- Propõe soluções: vários documentários apontam os problemas de inteligência artificial e o uso de decisões automatizadas, porém boa parte deles esquecem de também propor as soluções. O documentário em questão mostra que a sociedade precisa discutir e criar leis e regulamentações tanto para o Estado, quanto para as corporações. Hoje em dia no Brasil, temos a LGPD (Lei Geral de Proteção de Dados) e, na Europa, a GDPR (Regulamento Geral sobre a Proteção de Dados) que já iniciaram essa jornada.

Pontos negativos

O documentário consegue focar e passar sua mensagem principal, o que é ótimo, porém possui alguns pontos de melhoria.

- Tratar a tecnologia como uma entidade: eu, particularmente, nunca gosto quando os algoritmos são tratados como seres ou entidades que estão realizando ações como “estou colhendo seus dados e tomando decisões que mudarão sua vida”. Esse tipo de recurso cria um distanciamento entre a pessoa sem conhecimento da área e a tecnologia, transformando em algo muito longe e etéreo, além de “pintar” a AI e o aprendizado de máquina como ferramentas exclusivamente negativas.

Black-box

Existem duas áreas de AI que vêm ganhando alguma tração ultimamente e são justamente ética e transparência. Novamente, penso que o documentário, com o intuito de facilitar o conteúdo, acaba transformando aprendizado de máquina numa caixa-preta que toma decisões sem ninguém saber o motivo. Alguns algoritmos realmente são mais difíceis de se entender, porém já existem bibliotecas (LIME, shap, shapash) que conseguem mostrar quais fatores foram levados em consideração para uma decisão do modelo. Porém, considero muito importante essa discussão sobre explicabilidade em cenários em que as pessoas são diretamente afetadas.

Importante salientar que existem algumas definições importantes quanto à questão de “caixa-preta” e interpretabilidade:

- Transparência: entender como um algoritmo cria um modelo, como ele funciona (independentemente do dado)

- Interpretabilidade global do modelo: como um modelo está fazendo as previsões depois de ser treinado de uma maneira geral, quais características são mais importantes para o processo de classificação

- Interpretabilidade local do modelo: entender os motivos e as explicações de uma classificação específica.

Para entender melhor dessa questão

Interpretable Machine Learning

A Guide for Making Black Box Models Explainable.

Conclusão

AI e tecnologia no geral possibilitam o crescimento e evolução da sociedade, mas, como quase todos os avanços da ciência, podem ser usados para o bem e para o mal. Estamos no momento da virada com relação às tecnologias de aprendizado de máquina aplicadas no dia a dia e, por isso, é tão importante prestarmos bastante atenção aos seguintes pontos:

- Onde essa tecnologia está sendo aplicada: faz total sentido ter um algoritmo que te ajuda a escolher qual a próxima música, filme ou comida você vai consumir e os cuidados com isso são bem menores do que com um modelo que definirá seu crédito no banco. Áreas como vigilância, segurança e saúde terão que absorver essas tecnologias de maneira mais lenta, para que a segurança, privacidade e liberdade das pessoas sejam respeitadas.

- Empresas e profissionais: todas as empresas e profissionais da área devem entender seu papel nessa revolução. Todos temos responsabilidades para criar, questionar e buscar um impacto positivo no que criamos.

Esse foi apenas um texto sobre o conteúdo do documentário. Uma análise cinematográfica seria bem diferente, porém, é muito difícil separar as duas coisas, dado que o como se passa a mensagem é, muitas vezes, tão importante quanto o conteúdo da mensagem em si. A questão de a narrativa do documentário pular de um assunto para o outro sem uma conexão muito clara me incomodou, além de terem “inventado” um HAL (2001 — Odisséia no Espaço) para ficar “falando” com o espectador, o que eu achei bem brega.

GPT3 GPT4 BARD e outras LLM (large language models)

Muitos leitores deste post provavelmente já estão familiarizados com os LLM (large language models) ou pelo menos já se depararam com conteúdo relacionado ao GPT. Se você não está familiarizado com as LLM, recomendo que confira este link para uma introdução.

É importante notar que a discussão em torno desses modelos é complexa, então vou me concentrar em conectá-los à discussão do filme, com a possibilidade de explorar o tópico mais a fundo em um futuro post.

Grandes modelos de linguagem, como o GPT-4 (da OpenAI), têm sido um tópico de discussão devido ao seu potencial impacto na sociedade. Esses modelos são treinados em vastas quantidades de dados e podem gerar texto semelhante ao humano, levantando preocupações sobre suas implicações éticas e possíveis vieses.

Semelhante às questões levantadas no documentário Coded Bias, grandes modelos de linguagem também podem perpetuar vieses presentes nos dados em que são treinados. Isso pode levar à geração de conteúdo tendencioso, sexista ou racista, que pode ter consequências negativas para a sociedade.

Além disso, o uso de grandes modelos de linguagem em várias aplicações, como geração de conteúdo, tradução e resumo, pode influenciar a opinião pública e os processos de tomada de decisão. Isso destaca a necessidade de regulamentações e diretrizes para garantir que esses modelos sejam usados de maneira responsável e ética.

Finalizando

Para você que chegou ao final do texto fica aqui uma dica: o vídeo da Isabela Furtado, Marina Tavares e Karla Gonçalves que cobre a questão de AI e o uso do feminino nos bots e robôs assistentes.

Rebelião das máquinas e robôs feminizados: discutindo fronteiras